lucas (@lucas_flatwhite)

2025-12-11 | ❤️ 31 | 🔁 7

오.. 재미있는 프로젝트! 해커뉴스 스레드에서 Gemini 3가 10년 후, 프론트페이지를 환각으로 생성한 걸 봄.

실제 2015년 12월 HN 아카이브를 LLM으로 ‘회고’ 분석하면 재미있을 거라 생각한데서 시작함. 아니 어찌 이런 생각을?!

카파시는 ChatGPT 5.1 Thinking을 써서 한 번 테스트해 보니, 수동으로 읽는 것보다 훨씬 세밀하고 흥미로운 분석이 나왔음. 그래서 Opus 4.5로 코딩하며 프로젝트를 완성함. (코딩은 Opus 라니까)

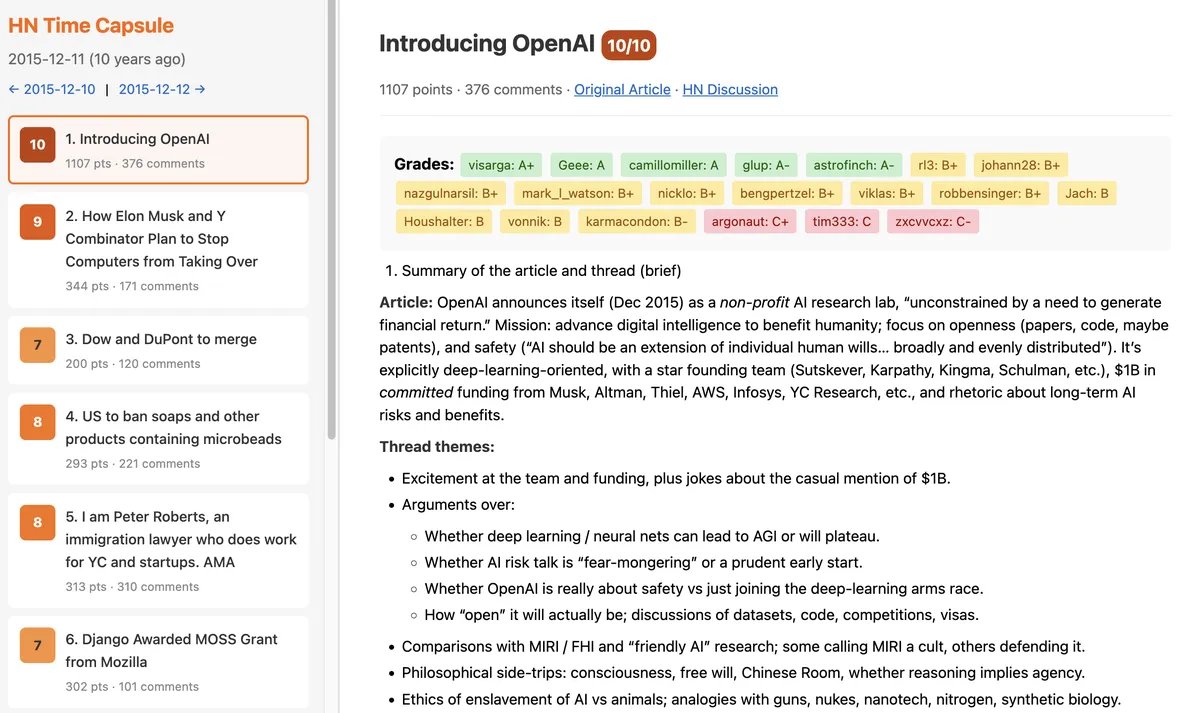

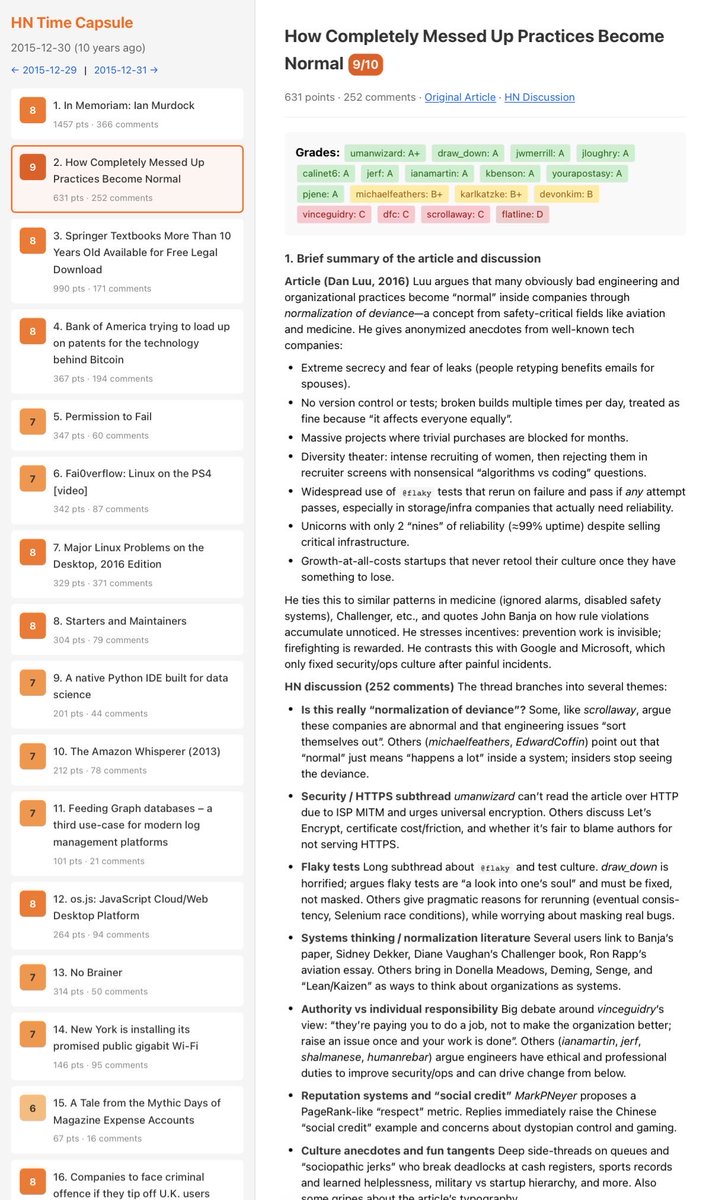

10년전 2015년 12월 31일간의 HN 프론트페이지를 다운로드함. 하루 30개 기사 수준인 듯. 각 기사 본문과 댓글 스레드를 Algolia API로 수집함.

이걸 마크다운 프롬프트로 패키징해 LLM에 제출하는데, 프롬프트는 6개 섹션으로 구성됨.

- 기사와 토론 요약

- 주제의 실제 후속 결과(간단 연구 요약)

- ‘가장 예언적’과 ‘가장 틀린’ 댓글 수상

- 기사나 토론의 재미있거나 주목할 점

- 특정 유저의 댓글 등급 (예: A+, F 등, 형식화된 리스트로 누적 가능)

- 전체 흥미도 점수 (0-10, 회고적으로 유명하거나 예측이 많을수록 높음)

이 분석이 두 가지 큰 이유로 흥미로운 이유..

첫째, 미래 예측 능력을 훈련할 수 있다는 점. 둘째, “미래 LLM이 지켜보고 있다”는 아이디어

오늘의 모든 행동이 미래에 무료로 재구성될 수 있으니, 지금부터 좋은 행동을 하라는 일종의 경고?

3시간 만에 vibe 코딩으로 끝남. 총 31일 × 30기사 = 930회 LLM 쿼리, 비용 $58

호스팅 ㄱㄱ https://karpathy.ai/hncapsule/

GitHub 여기 https://github.com/karpathy/hn-time-capsule

중간 데이터는 https://t.co/ObMJrPwTQp으로 공개. 예시 스레드 몇 개를 골라 보여주고, Hall of Fame 페이지에선 12월 전체 유저 GPA(등급 평균)로 랭킹 ㅋㅋ

미래 LLM은 이걸 더 쉽고 싸게 할 테지만, 지금은 꽤 재미있는 역사 탐구~~~

🔗 원본 링크

- https://karpathy.ai/hncapsule/

- https://github.com/karpathy/hn-time-capsule

- https://t.co/ObMJrPwTQp으로

미디어

인용 트윗

Andrej Karpathy (@karpathy)

Quick new post: Auto-grading decade-old Hacker News discussions with hindsight

I took all the 930 frontpage Hacker News article+discussion of December 2015 and asked the GPT 5.1 Thinking API to do an in-hindsight analysis to identify the most/least prescient comments. This took ~3 hours to vibe code and ~1 hour and $60 to run. The idea was sparked by the HN article yesterday where Gemini 3 was asked to hallucinate the HN front page one decade forward.

More generally:

- in-hindsight analysis has always fascinated me as a way to train your forward prediction model so reading the results is really interesting and

- it’s worth contemplating what it looks like when LLM megaminds of the future can do this kind of work a lot cheaper, faster and better. Every single bit of information you contribute to the internet can (and probably will be) scrutinized in great detail if it is “free”. Hence also my earlier tweet from a while back - “be good, future LLMs are watching”.

Congrats to the top 10 accounts pcwalton, tptacek, paulmd, cstross, greglindahl, moxie, hannob, 0xcde4c3db, Manishearth, and johncolanduoni - GPT 5.1 Thinking found your comments to be the most insightful and prescient of all comments of HN in December of 2015.

Links:

- A lot more detail in my blog post https://t.co/7LpJEVgbyk

- GitHub repo of the project if you’d like to play https://t.co/WVQUbUzt2y

- The actual results pages for your reading pleasure https://t.co/e2XIYElnc5